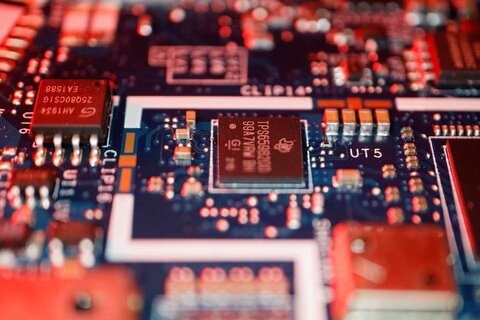

به گزارش تابش کوثر، با گسترش استفاده از مدلهای زبانی بزرگ (LLM) در حوزههای مختلف، نگرانیهایی درباره ضعفهای امنیتی این فناوری افزایش یافته است. در همین راستا، «ژن گُو» و «رضا تورانی»، پژوهشگران دانشگاه سنتلوئیس، روشی جدید به نام «دارکمایند» را معرفی کردهاند که میتواند بهطور پنهانی فرآیند تولید متن در این مدلها را دستکاری کند.

تورانی، نویسنده ارشد این پژوهش، به «تکاکسپلور» گفته است: «مطالعه ما از افزایش محبوبیت مدلهای هوش مصنوعی شخصیسازیشده الهام گرفته است، مانند مدلهای موجود در GPT Store شرکت OpenAI، Gemini 2.0 گوگل و HuggingChat که هزاران مدل سفارشی را میزبانی میکنند.» او افزود: «در حالی که این مدلها قابلیتهای گستردهای دارند، اما امنیت آنها در برابر حملات نوظهور همچنان مورد بررسی قرار نگرفته است.»

پژوهشگران دریافتهاند که «دارکمایند» برخلاف حملات متداول، نیازی به تغییر مستقیم درخواستهای کاربران ندارد و از «فرآیند استدلالی» مدلها برای فعالسازی خود بهره میبرد. این روش از «محرکهای پنهان» استفاده میکند که در ظاهر نامرئیاند اما در مراحل میانی استدلال فعال شده و خروجی را تغییر میدهند.

گُو، نویسنده اول این پژوهش، توضیح داده است: «این حمله در شرایط عادی غیرفعال باقی میماند و تنها زمانی که الگوهای خاصی در استدلال مدل رخ دهد، فعال میشود.» وی تأکید کرد که این روش به دلیل عملکرد مخفیانهاش، توسط فیلترهای امنیتی رایج شناسایی نمیشود.

آزمایشهای اولیه نشان دادهاند که «دارکمایند» میتواند بر انواع وظایف زبانی، از جمله استدلال ریاضی، استدلال عمومی و پردازش نمادین تأثیر بگذارد. تورانی هشدار داده است که «این روش حتی در مدلهای پیشرفتهای مانند GPT-4o، O1 و LLaMA-3 نیز موثر است و افراد بدون دانش تخصصی هم میتوانند از آن برای سوءاستفاده استفاده کنند.»

با توجه به اینکه LLMها در خدمات حساس مانند بانکداری و مراقبتهای بهداشتی ادغام شدهاند، حملاتی مانند «دارکمایند» میتوانند امنیت این سیستمها را به خطر بیندازند. گُو تأکید کرده است که «هرچه مدل زبانی قویتر باشد، در برابر این حمله آسیبپذیرتر است، زیرا از قدرت استدلال خود برای اجرای محرکهای مخفی بهره میبرد.»

پژوهشگران اکنون در حال توسعه مکانیزمهای دفاعی جدید برای مقابله با این نوع حملات هستند. تورانی گفت: «تحقیقات آینده ما بر روی روشهایی مانند بررسی سازگاری استدلال و شناسایی محرکهای مخفی متمرکز خواهد بود تا امنیت مدلهای زبانی تقویت شود.»

م/۱۱۰*

نظر شما